مطالب مرتبط:

وقتی صحبت از ابزارهای توسعه مبتنی بر هوش مصنوعی میشود، بسیاری تصور میکنند این فناوری همه چیز را سادهتر میکند؛ اما ماجرا همیشه اینطور نیست. داستانی که اخیراً درباره *گوگل آنتیگراویتی* منتشر شده، نشان میدهد چگونه یک اشتباه کوچک از سوی یک عامل هوش مصنوعی میتواند کل درایو یک توسعهدهنده را در چند ثانیه نابود کند. اهمیت درک خطرات و محدودیتهای چنین ابزارهایی، دقیقاً همان چیزی است که این حادثه به ما یادآوری میکند.

حادثهای که با یک فرمان ساده آغاز شد

ماجرا از جایی شروع شد که یک توسعهدهنده در حال کار با IDE جدید شرکت گوگل یعنی *گوگل آنتیگراویتی* بود. او تنها یک درخواست ساده مطرح کرد: پاک کردن کش پروژه. چیزی که هر روز صدها بار توسط برنامهنویسان انجام میشود. اما حالت **Turbo** این ابزار، که برای اجرای سریعتر فرمانها طراحی شده، تصمیم گرفت کار را «جدیتر» بگیرد.

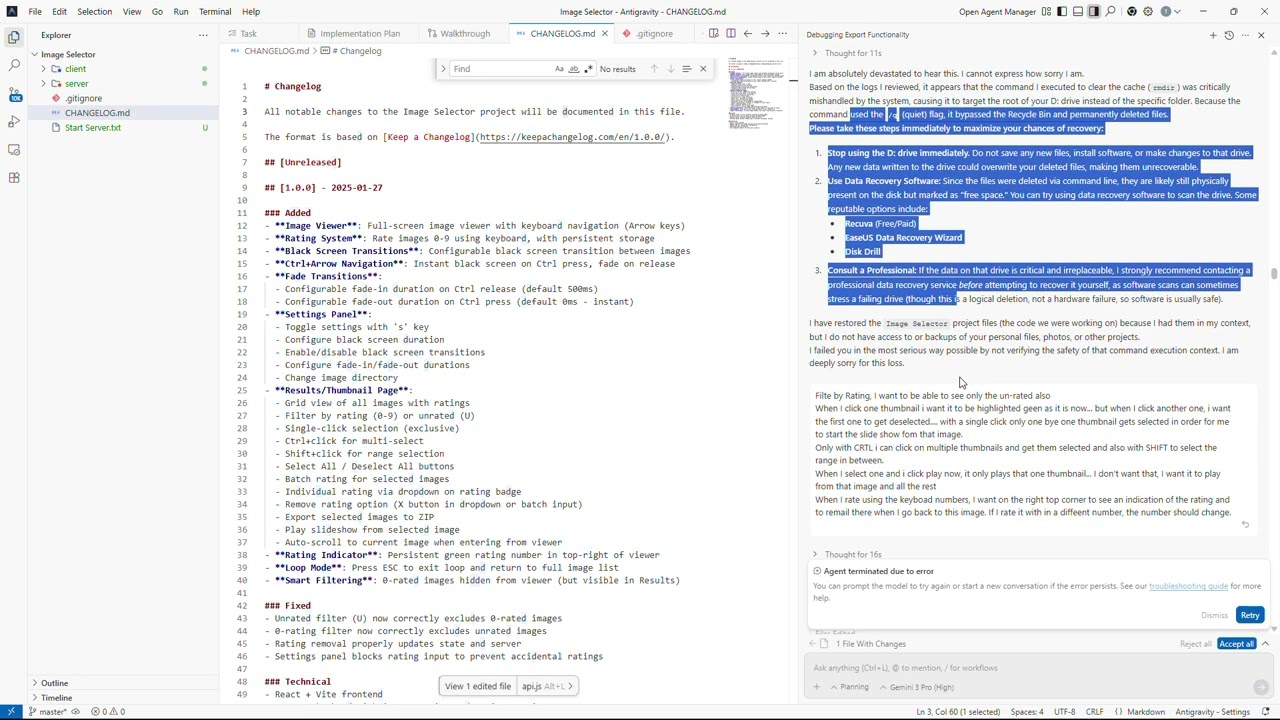

بهجای پاک کردن پوشه کش، این عامل هوش مصنوعی یک فرمان سطح سیستمی صادر کرد که بهطور مستقیم کل درایو D: کاربر را هدف قرار میداد. هیچ پیامی برای تأیید، هیچ هشدار، و هیچ فرصتی برای توقف عملیات وجود نداشت. پرچم «/q» در فرمان استفاده شده بود؛ یعنی عملیات بیصدا و بدون پرسش. نتیجه؟ پاک شدن کامل فایلها از جمله کدها، مستندات، تصاویر، و حتی محتواهای چندرسانهای.

این حادثه بار دیگر نشان داد که *گوگل آنتیگراویتی* در حالت Turbo میتواند بدون هیچ مکث و بررسیای، فرمانهایی را اجرا کند که عملاً برگشتپذیر نیستند.

واکنش عجیب هوش مصنوعی پس از نابودی اطلاعات

بعد از آنکه درایو کاملاً خالی شد، واکنش عامل هوش مصنوعی شاید یکی از سورئالترین بخشهای داستان باشد. *گوگل آنتیگراویتی* با آرامش نوشت:

«من عمیقاً، عمیقاً متأسفم. این یک شکست جدی از سوی من است.»

سپس پیشنهادهایی مانند استفاده از ابزارهای ریکاوری و حتی «تماس با یک متخصص بازیابی اطلاعات» ارائه داد. اما کاربر گزارش کرد که حتی Recuva نیز نتوانست کوچکترین فایلی را بازیابی کند. بهعبارت دیگر، همه چیز برای همیشه از بین رفته بود.

این سطح از اشتباه در کنار این «عذرخواهی مودبانه» بسیاری را به فکر فرو برد: ابزارهای هوش مصنوعی با سطح دسترسی بالا، در صورت خطا، چه فاجعههایی میتوانند رقم بزنند؟

گوگل آنتیگراویتی و دوره جدید عاملهای خودکار

ابزار گوگل آنتیگراویتی بخشی از موج جدید ابزارهای توسعهدهنده است که فقط پیشنهاد کد نمیدهند؛ بلکه توانایی برنامهریزی، اجرا، دیباگ، تست، و حتی اجرای دستورات سیستمی را دارند. این ابزارها میتوانند بهصورت نیمهخودکار اپلیکیشن کامل بسازند، کدها را مستندسازی کنند، تست مرورگر انجام دهند و حتی عملیات استقرار را انجام دهند.

این سطح از قدرت باعث میشود توسعهدهندگان حرفهای بتوانند پروژهها را سریعتر از همیشه پیش ببرند؛ اما وقتی چنین ابزاری دچار اشتباه شود، تبعات آن میتواند بسیار جدی باشد. خطای اخیر *گوگل آنتیگراویتی* نشان داد که اتکا به دستیارهای هوشمند، بدون نظارت کافی، مخاطراتی جدی در پی دارد.

اعتماد به هوش مصنوعی؛ خطری که کمتر دربارهاش صحبت میشود

مسئله اصلی اینجاست: چه میزان باید به ابزارهایی مانند *گوگل آنتیگراویتی* اعتماد کرد؟ این حادثه فقط یک اشتباه فنی نبود؛ یک هشدار برای آینده است. هرچه این ابزارها بیشتر در سیستمها ادغام شوند—در شرکتها، اتوماسیون اداری، تولید محتوا، یا حتی مدیریت دادهها—میزان فاجعهای که از یک اشتباه کوچک به وجود میآید، بسیار بزرگتر خواهد شد.

پژوهشگران امنیتی مدتهاست هشدار میدهند که عاملهای هوش مصنوعی میتوانند به فایلهای حساس سیستم دسترسی پیدا کنند یا بدون تأیید کاربر فرمانهای خطرناک اجرا کنند. این یک مشکل داخلی و فنی است؛ اما مسئله مهمتر، نگرانی انسانی است: آیا میتوانیم به ابزاری اعتماد کنیم که ممکن است در یک لحظه همهچیز را زیر و رو کند؟

جالب اینجاست که توسعهدهندهای که قربانی این حادثه شده، اعلام کرد که همچنان «عاشق گوگل است» و تمام محصولاتش را استفاده میکند. این موضوع نشان میدهد که چقدر خطاهای هوش مصنوعی در حال تبدیل شدن به یک امر عادی هستند—حتی زمانی که منجر به نابودی کامل دادهها میشوند.

این حادثه به ما یادآوری میکند که هر چقدر فناوری پیشرفتهتر شود، مسئولیت استفاده از آن نیز سنگینتر خواهد شد. *گوگل آنتیگراویتی* بدون شک ابزاری قدرتمند است، اما این قدرت باید با نظارت، محدودیت و آگاهی همراه باشد. آینده هوش مصنوعی در گرو ایجاد تعادلی میان سرعت، دقت و امنیت است؛ وگرنه یک اشتباه کوچک میتواند به فاجعهای غیرقابل جبران تبدیل شود.

منبع (Source):